iPhone 16 Pro購入、大阪出張、高校授業

2024-12-14 日本語

iPhone SE(初代から3世代目まで)をずーっと使っていましたが、バッテリのへたりも気になってきたので、満を持して iPhone 16 Proに移行してみました。Android(Google Pixelとか)も悪くなさそうとは見ていたんですが、AppleWatchはまだ使いたいし、Macの方との連携も細々あるしなぁ…ということで、結局、元鞘に収まる格好です。これって、次にWatchやMacを買い替えとなった時に同じ理由でAppleを選ぶことになりそうで、見事に囲い込まれてますね(笑)

Ubuntu(Linux)をメイン機にしようかという構想はずっとあるのですが、RaspberryPiでやりたいことの大部分が出来てしてしまっているので、積極的に移行するモチベーションが無いというのもあります。

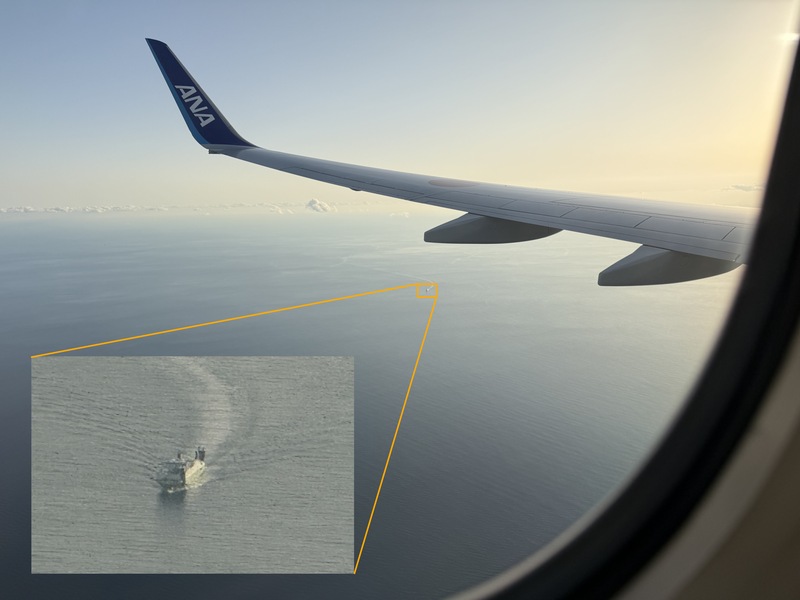

話を戻して、iPhoneのProシリーズになると、もはやカメラにその他の機能が付いてるみたいなくらいカメラ性能に注力してる感じなんですね(主観です)。ズーム機能を試してみましたが、どうやってあの薄いカメラでこんなことが出来るのか不思議でなりません(^^;

上の写真は久しぶりの大阪出張の帰りに撮ったものです。大阪(での仕事)ももう人生の一部と言えるくらい長丁場でお世話になっています。一番長いのは名古屋のクライアントですが、もう20年近くも前の、リモートワークなんて言葉もなかったくらいの頃にそういう働き方を認めてくれていたことには感謝しきれません(業務委託なんだから当然の権利、と見るのはエンジニア側の都合であって、お金を払う側からしたら近くにいてくれて、ちょっとした時にコミュニケーションが取れる方が便利ではあるはずです)。

土曜日は北高校にお邪魔してGoogle Colabを使った授業をお手伝いさせて頂きました。タブレットで動画を撮って、クラウドにアップロードし、クラウド上のコンピューティングリソース(Colab)を使って画像解析のプログラムを一人一人が実際に走らせてみることが出来る、って凄い時代になったな!と感動します。

以下は動画内の人物のポーズを検出し、それぞれの右手首の軌跡をプロットするというサンプルです。厳密に追跡する方法が見つからなくて一瞬おかしくなるタイミングもあるのですが、ここまで出来たら色々と応用も見つかりそう、ということで、どんな試行錯誤が生まれるのか楽しみです。

blur.meというサービスを使って、加工した写真↓ なんか自動化のレベルが一段あがって当たり前になってしまいましたね。